Golpes como o uso da imagem de William Bonner para anunciar indenização para vítimas de vazamento de dados do Serasa proliferam no Brasil

Deepfakes são um tipo de inteligência artificial (IA) que pode criar imagens, vídeos e áudio realistas e convincentes criados ou manipulados sinteticamente. Deepfakes podem representar uma ameaça à privacidade e à segurança de empresas e indivíduos e podem ser usados para diversos fins maliciosos, incluindo: golpes de phishing, roubo de identidade e ataques automatizados de desinformação como fake news.

No início de 2024, as redes sociais foram inundadas com um vídeo adulterado do Jornal Nacional, no qual são usadas imagens do jornalista William Bonner para anunciar que o governo federal havia condenado a Serasa a pagar uma indenização de R$ 30 mil para cada pessoa que teria sido vítima de um vazamento de dados ocorrido na companhia em 2021.

O episódio foi apenas mais um exemplo de como o Brasil entrou na rota dos criminosos que usam o chamado deepfake para aplicar golpes das mais variadas formas em todo o mundo. Por conta do crescimento desses casos, a empresa de consultoria e pesquisas Markets and Markets estima que os investimentos destinados a detectar o uso de imagens falsas serão inevitáveis e deverão crescer ao ritmo de 41,6% ao ano nos próximos cinco anos.

Segundo o estudo, os gastos com as ferramentas de segurança para esta finalidade saltarão de seiscentos milhões de dólares em 2024 para perto de quatro bilhões até 2029. Os autores do trabalho avaliam que as principais razões para o crescimento exponencial sejam a preocupação com os riscos reputacionais além do temor relacionado às responsabilidades legais sobre o uso indevido de dados de clientes. Na avaliação da consultoria, a crescente sofisticação das ferramentas de manipulação de imagens e a rápida disseminação de imagens falsas em várias plataformas online levarão as organizações à necessidade de enfrentarem fiscalizações mais rigorosas dos governos e até punições caso não comprovem a adoção de esforços e ferramentas para barrar a disseminação do deepfake.

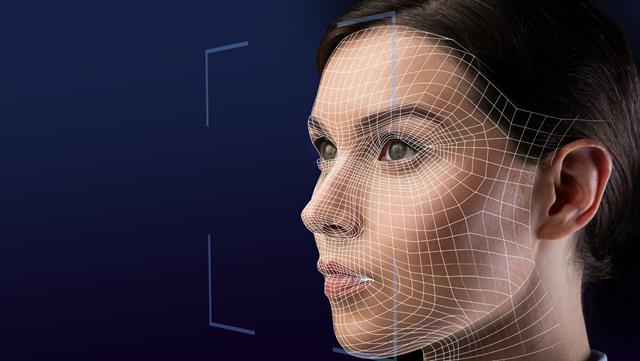

Uma das ferramentas mais eficientes de defesa para o deepfake é o chamado Liveness Passivo, mecanismo de mapeamento facial muito mais completo, alimentado por Inteligência Artificial que é capaz de determinar se a imagem de um rosto corresponde mesmo ao de uma pessoa real, se é apenas uma foto imóvel extraída de outra foto ou de alguém com uma máscara, por exemplo.

De acordo com Fernando Guimarães, head da Stone Age, vertical de negócios da TIVIT especializada em onboarding digital, que oferece uma das mais modernas e robustas soluções de Liveness Passivo do Brasil. A solução da TIVIT é capaz de identificar com bastante precisão as iniciativas fraudulentas que utilizam Inteligência Artificial (IA) para plotar uma face aleatória sobre a face verdadeira de alguém.

“Os riscos operacionais são cada vez maiores e as regulamentações crescentes farão com que, em pouco tempo, a adoção de instrumentos de Liveness Passivo seja praticamente obrigatória, especialmente para organizações que processam grandes volumes de dados de terceiros”, afirma Fernando.

Segundo a Markets and Markets os principais produtos anti deepfake no mundo empregam algoritmos baseados em machine learning para analisar profundamente as imagens em busca de sinais de manipulação ou alteração.

Os indícios mais significativos procurados por elas vão desde inconsistências de pixels até deficiências ou diferenças em termos de iluminação entre outros padrões que caracterizam as falsificações.

Sobre a TIVIT

A TIVIT é uma multinacional brasileira que acelera negócios conectando tecnologia para um mundo melhor. Com 25 anos de atuação e operações em dez países da América Latina, a companhia